「説明可能なAI」とは?人工知能は2つのタイプに分化する

- テクノロジー

AIの発展と現在の課題

「説明可能なAI」という言葉をご存知でしょうか?売上の予測やマッチングサービス、顔認識、画像の生成などに活用され、発展が著しいAI(人工知能)の世界において非常に大切なキーワードとなっています。

AIは、人間がルールを決めるところからスタートし、データを与えてAI自らが学習する「機械学習」という技術が1980年代以降に発展しました。これは人間がルールを与えずとも、着目すべき「特徴量(対象の特徴が数値化されたもの)」を指定することでAIが自ら学習して判断することができるようになるものです。

さらに、2000年代に入ると「ディープラーニング」という技術が大きく発展を見せました。ディープラーニングは、人間の脳の神経構造を模したニューラルネットワークを用いて、AIがデータそのものを教師として学習し、自動的に特徴量を抽出するというものです。どんな特徴を抽出するかについてAI任せにでき、人間が特徴量を明示することが難しい複雑な問題に対してもAIを適用できるようになりました。

このディープラーニングの実用化によって、AIの可能性は飛躍的に高まりました。特に「画像認識」「音声認識」「自然言語処理」「レコメンデーション」の分野で画期的な進歩があり、現在の我々の生活の中でも大いに活躍しています。しかし、ひとつ大きな問題となるのは、特徴量を自動抽出するその特性から、「判断プロセスがブラックボックスである」という点です。つまりAIが出した結論の根拠が説明可能ではないのです。

なぜ「説明」が必要か?

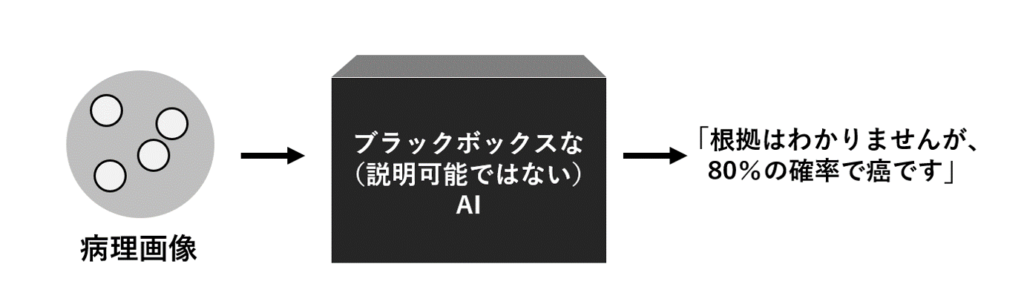

以前のコラムにも書いた通り、AIは明快な答えを提示するものではなく、確率や傾向値を算出するものです。例えば、病理画像から癌かどうかを診断するプロセスにAIを活用したとしましょう。AIが「癌の確率が80%です。理由はわからないけれど」と出たとしても、その真偽を検証することは難しくなります(人間の医師が見る前の一次スクリーニングとしては意味がありますが)。

同様に例えば、その人の様々な生活上のデータを取りこんで、金融機関がいくらまでお金を貸せるかを判断する与信審査、市場投入の前にその商品がヒットするかどうかの判断(新商品開発)、特定の地域における犯罪発生予測・・・これらの分野については「理由はわからないけれど」は許されず、検証や納得感のために「どうしてそう判断したのか」という根拠を知る必要がなります。また、例えば企業の採用に活用した場合、学習する膨大なデータを通して、AIが人間の潜在的な差別の傾向を読み取り、助長してしまうようなことも考えられます。

一方、法規制の面でも問題があります。2018年5月25日に施行され、個人情報の取り扱い厳格化に大きな影響を与えたGDPR(General Data Protection Regulation = EU一般データ保護規則)では、消費者の「説明を求める権利」が規定されています。企業がアルゴリズムにより意思決定を行った場合(例えば個人情報をもとに与信審査などを行った場合)、個人はその判断について説明を求める権利を有することが規定されています。

進む研究とAIの分化

このような問題に対し、現在研究が進められているのが「説明可能なAI」です。

その実現には様々な手法・技術が考案されており、例えば「人間が行う説明方法を、AIに学習させる」というアプローチや、他にはAIのモデル内部で実行されるプロセスの各ステップを可視化したり、どの入力変数がどういった出力結果(予測、推定)に最も寄与するかを明示して説明しやすくする方法など、日本の大手企業も含めて研究が進められています。米国の国防高等研究計画局(DARPA)も、2017年5月から約80億円の予算を投じて、大学や研究所と連携した複数のプロジェクトを進めており、2021年には研究結果が公表される予定となっています。

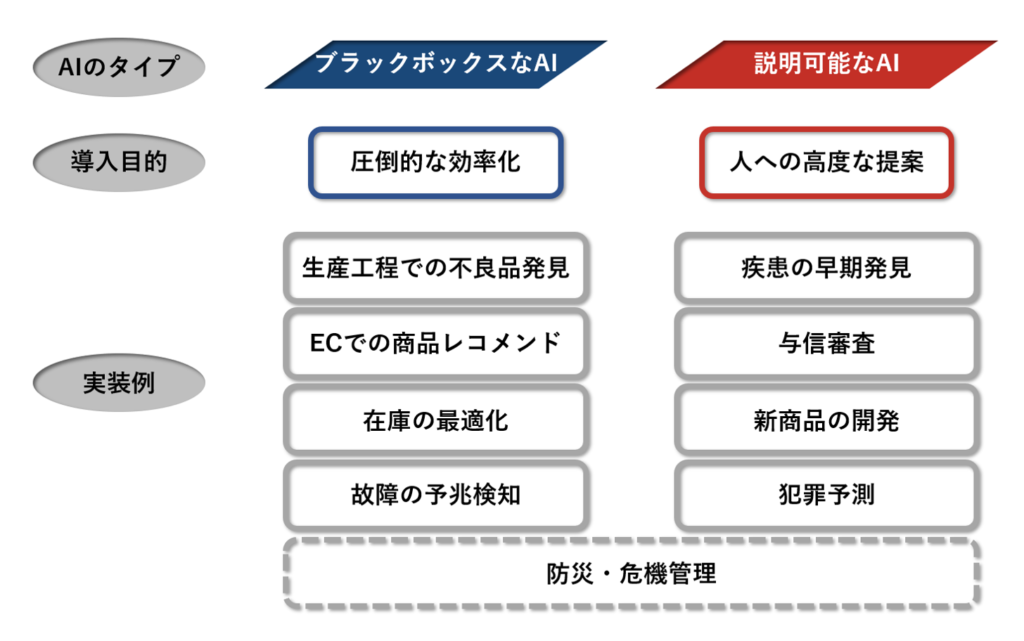

このような状況において、AIは大きく2つに分化していくのではないでしょうか。一つは、その結果に対する説明が不要な「ブラックボックスなAI」。生産工程における不良品発見やEコマースにおける商品のレコメンドなど、そこまで厳密な精度が求められるものではなく、活用の目的が「圧倒的な業務効率化」にあるものについては、説明がつかなくとも目的の達成に支障があるものではありません。

しかし一方で、「人への高度な提案」を目的とする活用もあります。上述したような与信審査や病理診断、新商品開発、犯罪予測などです。これらについてはなぜその結論が出たかのロジックを知る必要、つまり「説明可能なAI」であることが求められます。

防災・危機管理についてもAI技術の活用が進んでいますが、その間口は広く、例えば河川カメラなどの動画を人がずっと見張っていなくても、異常を検知して通知するような活用例であれば、ブラックボックスで構わないと考えられます。一方、気象データ・人流データ・河川の水位情報など複数のデータから避難指示を出すかどうか決定するというような「人への高度な提案」の活用例であれば、やはり説明可能なAIである必要が出てきます。

まだ研究は途上にありますが、ディープラーニングによる高度な処理を社会に実装していくにあたって非常に大切な要素となるため、今後も注視していきたいと考えています。

(根来 諭)

October 21, 2020

参考情報

「AIの説明」の現状とこれから(原聡 大阪大学産業科学研究所)

https://www.soumu.go.jp/main_content/000587311.pdf

The advantages of self-explainable AI over interpretable AI (The Nexte Web)

https://thenextweb.com/neural/2020/06/19/the-advantages-of-self-explainable-ai-over-interpretable-ai/

そもそもAI(人工知能)とは?その限界と可能性(スぺクティ)

https://spectee.co.jp/report/ai_limitation_and_possibility/